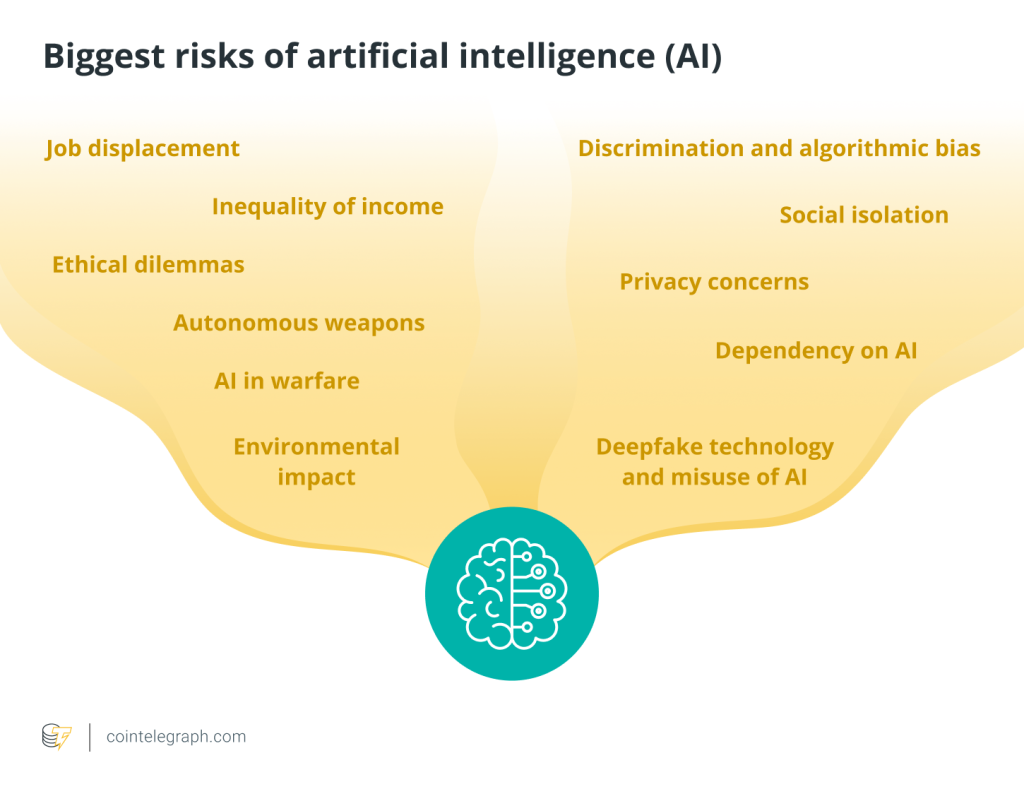

اگرچه هوش مصنوعی (AI) ذاتاً تهدیدی برای مردم نیست، اما اگر درست مانند هر ابزار قدرتمند دیگری به درستی از آن استفاده نشود، استفاده از آن میتواند خطرناک باشد. مسائلی مانند جابجایی شغلی، سوگیریهای الگوریتمی، تجاوز به حریم خصوصی و سوء استفاده احتمالی از سلاح های خودمختار یا سیستمهای نظارتی از جمله نگرانیهای رایج هستند.

نکته کلیدی در این است که مردم چگونه هوش مصنوعی را ایجاد، اداره و اعمال میکنند. توسعه مسئولانه هوش مصنوعی مستلزم استانداردهای اخلاقی، الگوریتم های منبع باز و حفاظت در برابر سوء استفاده است. در نهایت، انسانها باید اطمینان حاصل کنند که هوش مصنوعی باعث پیشرفت نوع بشر میشود و خطرات غیرقابل توجیهی ایجاد نمیکند.

اثرات منفی هوش مصنوعی

بدون شک، هوش مصنوعی کارایی و نوآوری را در بسیاری از جنبه های زندگی ما به ارمغان آورده است. اما استفاده گسترده از آن معایبی نیز دارد که باید به دقت مورد توجه قرار گیرد. رهبران برجسته فناوری، از جمله استیو وزنیاک، ایلان ماسک و استیون هاوکینگ، در سال 2015 نامه ای سرگشاده امضا کردند که در آن بر نیاز به تحقیقات گسترده در مورد اثرات اجتماعی هوش مصنوعی تاکید کردند.

موضوعات مطرح شده شامل نگرانی های ایمنی در مورد خودروهای خودران و بحث های اخلاقی در مورد سلاح های خود مختار مورد استفاده در درگیری ها است. این نامه همچنین آینده نگرانکنندهای را پیشبینی میکند که در آن انسانها ممکن است دیگر نتوانند هوش مصنوعی را کنترل کنند و حتی ممکن است به دلیل فقدان احتیاط کنترل بر اهداف و عملکردهای آن را از دست بدهند. تأثیر هوش مصنوعی با پیامدهای منفی، از معضلات اخلاقی گرفته تا اختلالات اقتصادی-اجتماعی همراه است.

جابجایی شغلی

نقشهای شغلی سنتی در صنایع مختلف به دلیل قابلیتهای اتوماسیون هوش مصنوعی در معرض خطر هستند. سیستم های مبتنی بر هوش مصنوعی می توانند جایگزین مشاغل تکراری در تولید، خدمات مشتری، ورود داده ها و حتی زمینه های تخصصی مانند حسابداری و قانون شوند. این جابجایی ممکن است منجر به بیکاری شود و نیاز به بازآموزی در مهارتهای جدید و سازگاری با محیط داشته باشد.

نابرابری درآمد

استفاده از فناوری هوش مصنوعی پتانسیل تشدید نابرابری اقتصادی را دارد. شرکتهای کوچکتر همگام شدن با شرکتهای بزرگتر را با منابع سرمایهگذاری در هوش مصنوعی دشوار میدانند. شکاف در دسترسی به ابزارهای مبتنی بر هوش مصنوعی این پتانسیل را دارد که شکاف اقتصادی بین شرکتهای بزرگ و مشاغل کوچکتر یا افراد را تشدید کند.

نگرانی های حریم خصوصی

داده های زیادی توسط سیستم های هوش مصنوعی جمع آوری و تجزیه و تحلیل می شود. این اتکا مشکلات جدی در حفظ حریم خصوصی ایجاد می کند. جمع آوری گسترده داده های شخصی توسط سیستم های هوش مصنوعی احتمال نقض داده ها و سوء استفاده را افزایش می دهد. امنیت و حریم خصوصی اطلاعات حساس می تواند با دسترسی غیرمجاز یا استفاده غیراخلاقی به خطر بیفتد.

به عنوان مثال، الگوریتمهای هوش مصنوعی متا به دلیل شیوههای مدیریت دادهها و نقض احتمالی حریم خصوصی مورد بررسی قرار گرفتند.

تبعیض و سوگیری الگوریتمی

از آنجایی که الگوریتمهای هوش مصنوعی با استفاده از دادههای موجود ایجاد میشوند، ممکن است تعصبات اجتماعی را تقویت کنند. این پیش داوری می تواند اشکال مختلفی داشته باشد، مانند احکام مغرضانه دادگاه یا شیوه های تبعیض آمیز استخدام. سیستمهای هوش مصنوعی کنترلنشده این پتانسیل را دارند که نابرابریهای موجود را تقویت کنند و با تقویت تعصبات اجتماعی نتایج ناعادلانهای بهدست آورند.

علاوه بر این، فناوریهای تشخیص چهره سوگیریهای نژادی و جنسیتی را نشان دادهاند. مطالعات نشان می دهد که برخی از سیستم ها افراد از گروه های قومی خاص را بیشتر به اشتباه شناسایی می کنند.

معضلات اخلاقی

هوش مصنوعی سوالات اخلاقی پیچیده ای را مطرح می کند. به عنوان مثال، دوراهی های اخلاقی در مورد تصمیم گیری در موقعیت های تهدید کننده زندگی با وسایل نقلیه خودران به وجود می آیند. توسعه تسلیحات مجهز به هوش مصنوعی همچنین سوالاتی را در مورد اخلاقی بودن تسلیحات خودمختار و امکان تشدید غیرقابل کنترل خصومت ها ایجاد میکند.

ایزوله سازی اجتماعی

افزایش انزوای اجتماعی می تواند ناشی از پیشرفت در فناوری های مبتنی بر هوش مصنوعی مانند دستیاران مجازی و روبات های اجتماعی باشد. اتکای بیش از حد به هوش مصنوعی برای تعامل اجتماعی می تواند بر سلامت روان و روابط بین فردی با فرسایش ارتباطات واقعی انسانی تأثیر منفی بگذارد.

وابستگی به هوش مصنوعی

اتکای بیش از حد به سیستم های هوش مصنوعی خطری است که با افزایش فراگیر آن همراه است. اتکای بیش از حد به هوش مصنوعی برای تصمیم گیری های حیاتی در صنایعی مانند مالی یا مراقبت های بهداشتی می تواند منجر به نظارت کمتر انسانی شود و دقت و مسئولیت پذیری را به خطر بیندازد.

سلاح های خودمختار

ظهور تسلیحات خودمختار مجهز به هوش مصنوعی نشان دهنده تغییر نگران کننده در درگیری است. این واقعیت که این ماشین ها به طور مستقل توسط انسان ها اداره می شوند، چالش های اخلاقی و عملی قابل توجهی را ایجاد می کند. فقدان نظارت انسانی در تصمیم گیری های رزمی یک نگرانی قابل توجه است. سرعت و استقلال این سلاح ها سؤالاتی را در مورد توانایی آنها در تشخیص ملاحظات اخلاقی یا اخلاقی در موقعیت های آشفته ایجاد می کند.

هوش مصنوعی در جنگ

علاوه بر این، از آنجایی که سیستمهای هوش مصنوعی به سرعت تصمیمگیری میکنند، استفاده از آنها در جنگ خطر قابل توجهی برای بدتر شدن خصومتها را به همراه دارد. این ابهامات با فقدان مقررات بینالمللی تثبیتشده حاکم بر استفاده از هوش مصنوعی در جنگ تشدید میشود و نیاز مبرم به استانداردهای اخلاقی و توافقهای چندملیتی برای کاهش خطرات احتمالی را برجسته میکند.

فناوری Deepfake و سوء استفاده از هوش مصنوعی

با وجود قابلیتهای فنآوری چشمگیر، فناوری دیپفیک در موقعیتهای مختلف خطرات جدی را برای حقیقت و اصالت به همراه دارد. دقت حقایق به دلیل این خلاقیتهای رسانهای مصنوعی فوقالعاده واقعی که میتوانند واقعی باشند در خطر است. یکی از نگرانی های اصلی استفاده نادرست از دیپ فیک برای انتشار تبلیغات و اطلاعات نادرست است. بازیگران بدخواه می توانند از این فناوری برای ساختن داستان هایی برای تحت تأثیر قرار دادن افکار عمومی، ایجاد هرج و مرج یا آسیب رساندن به شهرت استفاده کنند.

علاوه بر این، این نگرانکننده است که فناوری دیپفیک میتواند با ایجاد محتوای صریح یا تغییر صداها و تصاویر افراد، حریم خصوصی افراد را نقض کند. چالش تمایز محتوای واقعی از تولیدات دیپفیک، مقابله با گسترش آنها را پیچیدهتر میکند و نیاز حیاتی به تکنیکهای تشخیص خلاقانه و قوانین سختگیرانه برای حفظ اعتبار و اصالت در رسانهها و اشتراکگذاری اطلاعات را برجسته میکند.

اثرات زیست محیطی

برای برآوردن نیازهای محاسباتی هوش مصنوعی، به ویژه برای الگوریتمهای یادگیری عمیق، به قدرت محاسباتی قابل توجهی نیاز است . محیط زیست به دلیل این تقاضا، افزایش مصرف انرژی و انتشار کربن تحت فشار است.

آیا هوش مصنوعی می تواند جایگزین انسان شود؟

طبق آمار Statista.com، پیشبینی میشود تا سال 2030، بازار جهانی هوش مصنوعی 100 میلیارد دلاری، بیست برابر شده و به تقریباً 2 تریلیون دلار برسد . هوش مصنوعی به سرعت توسعه یافته است و در تجزیه و تحلیل داده ها، اتوماسیون وظایف و پشتیبانی تصمیم گیری ماهر شده است.

اما قدرت آن برای تکرار عمق و وسعت توانایی های انسان ناکافی است. علاوه بر این، هوش مصنوعی فاقد خلاقیت، هوش هیجانی و سازگاری انسان است، اما در زمینه های تخصصی مانند تولید و تشخیص پزشکی مهارت دارد.

از همه مهمتر، هوش مصنوعی وجود و تکامل خود را مدیون نبوغ انسان است. سیستمهای هوش مصنوعی توسط انسانها طراحی و ایجاد میشوند، بنابراین آنها در کاری که میتوانند انجام دهند محدود هستند. آنها نمی توانند ظرایف عاطفی، خلاقیت یا شهودی را که مشخصه تفکر انسان است، تکرار کنند. به عنوان مثال، در حالی که DeepMind گوگل ممکن است قادر به تشخیص دقیق بیماری های چشم و کمک به مداخلات پزشکی اولیه باشد، تخصص انسانی چنین سیستم های هوش مصنوعی را مفهوم سازی کرده و توسعه داده است.

علاوه بر این، هوش مصنوعی هنوز نمیتواند با هوش اجتماعی و عاطفی انسان، استدلال اخلاقی پیچیده، آگاهی زمینهای، سازگاری یا رهبری مطابقت نداشته باشد. هوش مصنوعی در کارهای خاص کارآمد است، همانطور که آمازون از ربات های مبتنی بر هوش مصنوعی برای ساده کردن عملیات انبار نشان داد. این تنها چند نمونه از کاربردهای عملی هوش مصنوعی است. با این حال، تصور، طراحی و ملاحظات اخلاقی این برنامههای کاربردی هوش مصنوعی هنوز هم تلاشهای بسیار انسانی است.

از آنجایی که هوش مصنوعی در پردازش مقادیر زیادی از داده ها خوب است و انسان ها در خلاقیت، همدلی و تصمیم گیری های پیچیده خوب هستند، کار با یکدیگر اغلب بهترین نتایج را به همراه دارد. ویژگیهای متمایز شناخت انسان که ریشه در تجربیات، احساسات و درک زمینهای دارد، در حال حاضر جایگزینی کامل با هوش مصنوعی را به یک سناریوی غیرمحتمل تبدیل میکند.

راه حل خطرات هوش مصنوعی چیست؟

پرداختن به خطرات مرتبط با هوش مصنوعی نیازمند رویکردی چندوجهی است که بر ملاحظات اخلاقی، مقررات و توسعه مسئولانه متمرکز است. اولاً، ایجاد چارچوبهای اخلاقی کامل که بر مسئولیتپذیری، عدالت و شفافیت تأکید دارد، ضروری است. قوانینی باید اجرا شوند تا تضمین شود که سیستمهای هوش مصنوعی از اصول اخلاقی پیروی میکنند و تعصب و تبعیض را کاهش میدهند.

علاوه بر این، تشویق همکاری بین سیاستگذاران، فنآوران، اخلاقشناسان و ذینفعان میتواند به ایجاد مقرراتی با اولویت ایمنی و رفاه مردم کمک کند. برای اطمینان از رعایت این استانداردها، مکانیسمهای نظارتی، ممیزی و نظارت مستمر لازم است.

سوگیری های هوش مصنوعی را می توان با ترویج تیم های توسعه فراگیر و متنوع کاهش داد. کاربرد اخلاقی هوش مصنوعی باید در کمپین های آموزشی و آگاهی بخشی مورد تاکید قرار گیرد. برای به حداکثر رساندن مزایای هوش مصنوعی و در عین حال کاهش خطرات آن، یک تلاش جمعی شامل استانداردهای اخلاقی، محدودیتهای قانونی، دیدگاههای متنوع و ارزیابی مستمر ضروری است.

نظرات کاربران